AIGC动态欢迎阅读

原标题:7B大模型测试成绩超GPT-4!微软新研究解决工具调用难题

关键字:模型,语言,工具,能力,方法

文章来源:智东西

内容字数:4200字

内容摘要:

微软靠“想象力”解决大语言模型调用工具两大难题!方法已开源。

作者|徐珊

编辑|云鹏

智东西3月10日消息,近日微软和俄亥俄州立大学的研究人员发布论文,提出了一种受到生物启发的可以增强大语言模型使用工具能力的方法,即模拟试错(STE)法,并将其开源。

该方法协调了试错、想象和记忆三个关键机制。具体而言,STE通过大模型的“想象力”来模拟使用工具的一些合理场景,从而尝试适配不同的大模型,随后从新的反馈中,获得反馈不断优化。

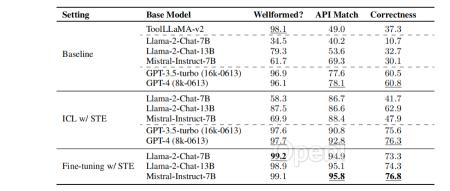

ToolBench实验结果显示,STE在上下文学习和微调设置下显著提高了大语言模型的工具学习能力,让Mistral-Instruct-7B实现了46.7%的性能提升,使其成绩超过了GPT-4。▲论文封面

论文PDF:https://arxiv.org/pdf/2403.04746.pdf

01.

无法兼顾准确性和灵活性,

大语言模型调用工具遭遇两大难题

寻找合适的工具一直以来都是训练大语言模型中关键一环。目前有关大语言模型的工具研究,主要集中在两个方面:为大语言模型增加一些新的工具,以及能够让大语言模型访问多个工具。

这些研究方向一般采用两种常见的设置:1)上下文学习

原文链接:7B大模型测试成绩超GPT-4!微软新研究解决工具调用难题

联系作者

文章来源:智东西

作者微信:zhidxcom

作者简介:智能产业新媒体!智东西专注报道人工智能主导的前沿技术发展,和技术应用带来的千行百业产业升级。聚焦智能变革,服务产业升级。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号