AIGC动态欢迎阅读

原标题:华为诺亚频域LLM「帝江」:仅需1/50训练成本,7B模型媲美LLaMA,推理加速5倍

关键字:模型,侵权,论文,注意力,复杂度

文章来源:算法邦

内容字数:6495字

内容摘要:

4月18-19日,由智猩猩与智东西共同主办的2024中国生成式AI大会将在北京JW万豪酒店举行。大会完整议程出炉,55位嘉宾出席!免费票申请通道即将关闭,大会通票(499元标准票)余票有限。扫码抢票~文章转载自公众号:机器之心,本文只做学术/技术分享,如有侵权,联系删文。

“又西三百五十里曰天山,多金玉,有青雄黄,英水出焉,而西南流注于汤谷。有神鸟,其状如黄囊,赤如丹火,六足四翼,浑敦无面目,是识歌舞,实惟帝江也。”——《山海经》

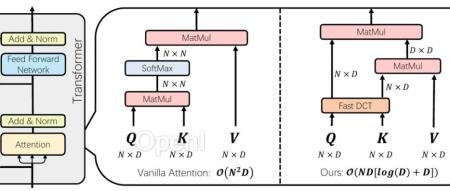

基于 Transformer 架构的大语言模型在 NLP 领域取得了令人惊艳的效果,然而,Transformer 中自注意力带来的二次复杂度使得大模型的推理成本和内存占用十分巨大,特别是在长序列的场景中。此前,研究者们提出了线性 Transformer、Mamba、RetNet 等。这些方案可以大幅降低 Transformer 计算成本,并且取得媲美原有模型的精度,但是由于架构更换,模型重训练带来的巨大成本令人望而却步。

为了解决这一问题,最近的一篇论文提出了一种基于频域的大语言模型架构 —帝江(源于山海经的一种神话生物,以跑得快而闻名),同时解决了现有大模

原文链接:华为诺亚频域LLM「帝江」:仅需1/50训练成本,7B模型媲美LLaMA,推理加速5倍

联系作者

文章来源:算法邦

作者微信:allplusai

作者简介:智猩猩矩阵账号之一,连接AI新青年,讲解研究成果,分享系统思考。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号