AIGC动态欢迎阅读

原标题:CVPR‘24:与任务无关的多模态数据也能提升Transformer性能|港中文&腾讯

关键字:腾讯,数据,模型,任务,线性

文章来源:量子位

内容字数:3708字

内容摘要:

Yiyuan 投稿量子位 | 公众号 QbitAI万万没想到,与任务无直接关联的多模态数据也能提升Transformer模型性能。

比如训练一个图像分类模型,除了标注好类别的图像数据集,增加视频、音频、点云等模态数据,也能显著提升模型在图像分类上的性能。

这样一来,在AI训练阶段就可以减少与特定任务直接相关的标注数据需求,可以节省大量成本,或在数据有限的任务上提供新解决思路。

这个神奇的发现来自港中文MMLab和腾讯AI Lab的合作研究,相关论文已被CVPR 2024接收,引起广泛关注。

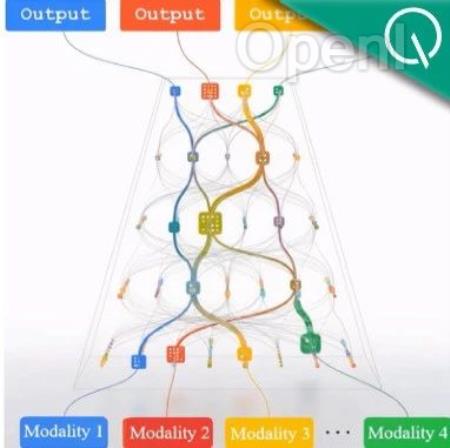

从无关数据中学习有用知识具体来说,团队提出了一种称为多模态通路(Multimodal Pathway)的新框架。

该框架允许Transformer模型在处理特定模态的数据时,同时利用其他模态中的无关数据进行训练,从而在不增加额外推理成本的前提下显著提升模型性能。

多模态通路的核心技术是跨模态重参数化(Cross-Modal Re-parameterization)*。

这一技术的创新之处在于,它通过结构上的智能重组,使得模型能够在保持原有计算成本的同时,增加从其他模态学习的能力。

对于已经被广泛运用

原文链接:CVPR‘24:与任务无关的多模态数据也能提升Transformer性能|港中文&腾讯

联系作者

文章来源:量子位

作者微信:QbitAI

作者简介:追踪人工智能新趋势,关注科技行业新突破

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号