AIGC动态欢迎阅读

原标题:强强联合!当RAG遇到长上下文,滑铁卢大学发布LongRAG,效果领先GPT-4 Turbo 50%

关键字:长上,单元,下文,阅读器,上下文

文章来源:夕小瑶科技说

内容字数:0字

内容摘要:

夕小瑶科技说 原创作者 | Axe_越过犹不及——《论语·先进》

大学考试时,有些老师允许带备cheet sheet(忘纸条),上面记着关键公式和定义,帮助我们快速作答提高分数。传统的检索增强生成(RAG)方法也类似,试图找出精准的知识片段来辅助大语言模型(LLM)。

但这种方法其实有问题。因为:

LLM没有”老师划重点”,需要自己在海量信息中寻找答案。

RAG是两步走:先检索,再生成。如果第一步检索就出错,再好的生成也难以弥补。

过分追求精准的知识片段,反而可能限制了模型的发挥空间。

所以,与其苛求检索结果的精准性,不如给模型提供更丰富的上下文信息,让它自己去理解和提炼关键知识。这样可能效果会更好。

那有没有可能让LLM不要cheet sheet,直接参加“开卷考”呢?随着现在长上下文技术(LongContext)日渐成熟,让LLM干脆带着“书”来回答问题开始成为可能。

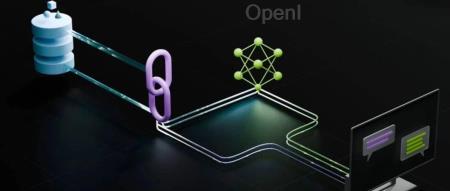

滑铁卢大学的研究者们就做了这么一个尝试,抛开当前“长上下文党”和“RAG党”之间的争论,把“长上下文”和“RAG”整个地结合了起来,反正就是“我全都要”。至于效果嘛?据说连GPT-4也已经被“吊打”了喔~

论文链接:

原文链接:强强联合!当RAG遇到长上下文,滑铁卢大学发布LongRAG,效果领先GPT-4 Turbo 50%

联系作者

文章来源:夕小瑶科技说

作者微信:xixiaoyaoQAQ

作者简介:专业、有趣、深度价值导向的科技媒体。聚集30万AI工程师、研究员,覆盖500多家海内外机构投资人,互联网大厂中高管和AI公司创始人。一线作者来自清北、国内外顶级AI实验室和大厂,兼备敏锐的行业嗅觉和洞察深度。商务合作:zym5189

粤公网安备 44011502001135号

粤公网安备 44011502001135号