AIGC动态欢迎阅读

原标题:Sigmoid注意力一样强,苹果开始重新审视注意力机制

关键字:注意力,序列,矩阵,函数,内存

文章来源:机器之心

内容字数:0字

内容摘要:

机器之心报道

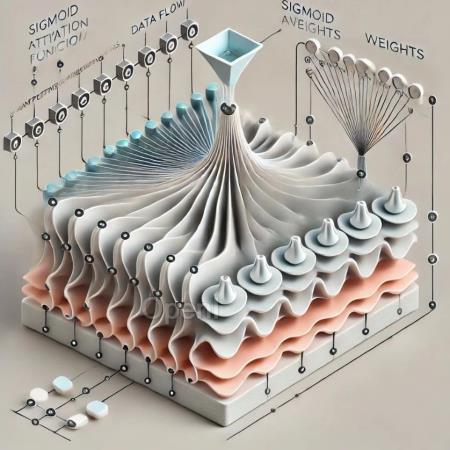

机器之心编辑部注意力是 Transformer 架构的关键部分,负责将每个序列元素转换为值的加权和。将查询与所有键进行点积,然后通过 softmax 函数归一化,会得到每个键对应的注意力权重。

尽管 SoftmaxAttn 中的 softmax 具有广泛的用途和有效性,但它并非没有局限性。例如,softmax 函数有时会导致注意力集中在少数几个特征,而忽略了其他信息。

近来,一些研究探索了 Transformer 中 softmax 注意力的替代方案,例如 ReLU 和 sigmoid 激活函数。最近,来自苹果的研究者重新审视了 sigmoid 注意力并进行了深入的理论和实验分析。

该研究证明:从理论上讲,与 softmax 注意力相比,具有 sigmoid 注意力的 Transformer 是通用函数逼近器,并且受益于改进的正则化。论文地址:https://arxiv.org/pdf/2409.04431

项目地址:https://github.com/apple/ml-sigmoid-attention

论文标题:Theory, Analysis, and Best

原文链接:Sigmoid注意力一样强,苹果开始重新审视注意力机制

联系作者

文章来源:机器之心

作者微信:

作者简介:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号