AIGC动态欢迎阅读

原标题:突破短视频局限!MMBench 团队构建中长视频开放问答评测基准,全面评估多模态大模型视频理解能力

关键字:模型,视频,基准,能力,时序

文章来源:量子位

内容字数:0字

内容摘要:

新宇投稿 凹非寺量子位 | 公众号 QbitAIGPT-4o 四月发布会掀起了视频理解的热潮,而开源领军者Qwen2也对视频毫不手软,在各个视频评测基准上狠狠秀了一把肌肉。

但当前的大部分评测基准仍然具有以下几个缺陷:

多注重于短视频,视频长度或视频镜头数不足,难以考察到模型的长时序理解能力;

对模型的考察局限在部分较为简单的任务,更多细粒度的能力未被大部分基准所涉及到;

现有的基准仍可以仅凭单帧图像以获取较高的分数,说明问题和画面的时序性关联不强;

对开放性问题的评估仍旧采用较旧的GPT-3.5,打分和人类偏好有较大的偏差且并不准确,容易高估模型性能。

针对这些问题,有没有对应的基准能够较好解决这些问题呢?

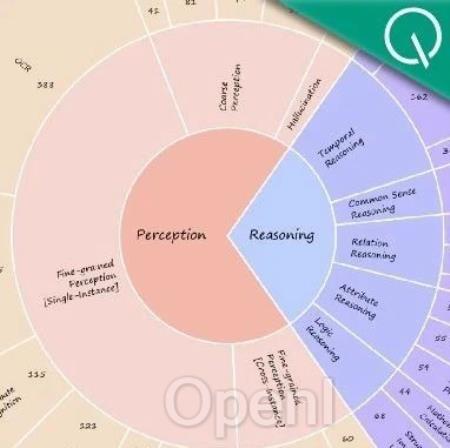

在最新的NeurIPS D&B 2024中由浙江大合上海人工智能实验室,上海交通大学和香港中文大学提出的MMBench-Video打造了一个全面的开放性视频理解评测基准,并针对当前主流MLLM构建了开源的视频理解能力评估榜单。

全能力链条覆盖高质量数据集

MMBench-Video这一视频理解评测基准采取全人工标注,历经一次标注和二次质量核验,视频种类丰富且质量高,问答涵盖模

原文链接:突破短视频局限!MMBench 团队构建中长视频开放问答评测基准,全面评估多模态大模型视频理解能力

联系作者

文章来源:量子位

作者微信:

作者简介:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号