AIGC动态欢迎阅读

原标题:微软清华改进Transformer:用降噪耳机原理升级注意力,一作在线答疑

关键字:注意力,上下文,噪声,准确率,模型

文章来源:量子位

内容字数:0字

内容摘要:

梦晨 发自 凹非寺量子位 | 公众号 QbitAITransformer自问世后就大放异彩,但有个小毛病一直没解决:

总爱把注意力放在不相关的内容上,也就是信噪比低。

现在微软亚研院、清华团队出手,提出全新改进版Differential Transformer,专治这个病,引起热议。

论文中介绍,整体思路类似差分放大电路或降噪耳机,用两个信号的差值来滤除共模噪声。

具体到在语言模型中,如果句子很长,只有少数token会真正影响当前token的含义。而注意力机制允许每两个词之间产生交互,其中就包含大量噪声了。

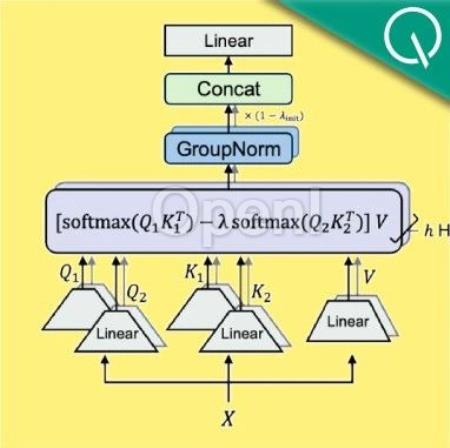

团队提出的方法是在注意力层中增加一个Softmax,然后两个Softmax做减法。

这一减,噪音信息就被大幅抵消,让注意力更集中在相关内容上。

语言建模任务上的一系列实验结果显示,仅需约65%的模型大小或训练tokens,DIFF Transformer就能达到与传统Transformer相当的性能。

新架构在长上下文建模、关键信息检索、减少幻觉、提高上下文学习能力以及减少激活异常值等各项指标中,普遍优于Transformer架构。

论文上传到arXiv平台后,有不少学者到弹幕

原文链接:微软清华改进Transformer:用降噪耳机原理升级注意力,一作在线答疑

联系作者

文章来源:量子位

作者微信:

作者简介:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号