MimicMotion是腾讯研究团队推出的一个先进的人类动作视频生成框架,旨在提供高质量的动态视频。该系统采用置信度感知的姿态引导技术,以确保视频帧的高质量和流畅的时间过渡。同时,通过区域损失放大和手部区域增强,MimicMotion在减少图像失真的同时,显著提升了手部动作的细节表现。

MimicMotion是什么

MimicMotion是腾讯的研究团队开发的一个高效能的人类动作视频生成框架。它利用置信度感知的姿态引导技术,确保生成视频帧的高质量以及时间上的平滑过渡。此外,MimicMotion通过区域损失放大和手部区域增强,有效减少了图像失真,提升了人像手部动作的细节表现。该框架还能够通过渐进式潜在融合策略生成长时间的视频,确保高质量和时间一致性,符合用户所需的特定动作指导。

MimicMotion的主要功能

- 生成多样化视频:MimicMotion可以根据用户提供的姿态指导,生成丰富多样的动作视频,包括舞蹈、以及日常活动等,只需提供相应的姿态序列。

- 灵活控制视频长度:用户可以根据需求指定视频的时长,从短片段到长达几分钟的完整视频,提供了灵活的适应性以满足不同场景的需要。

- 姿态引导控制:该框架采用参考姿态作为条件,确保生成的视频与指定姿态保持一致性,实现高度定制化的视频生成。

- 细节质量保障:MimicMotion特别关注视频中的细节,尤其是手部等容易失真的区域,确保这些区域的视觉效果清晰锐利。

- 时间平滑性:MimicMotion确保视频帧之间的平滑过渡,提供更自然的观看体验,避免出现卡顿或不连贯的现象。

- 减少图像失真:通过置信度感知的姿态引导,MimicMotion能够识别并减少由于姿态估计不准确导致的图像失真,尤其是在人物手部区域。

- 长视频生成:MimicMotion采用渐进式潜在融合技术,在生成长视频时保持高时间连贯性,有效避免了闪烁和不连贯的现象。

- 资源消耗控制:MimicMotion优化了生成视频的算法,确保在计算资源上保持合理范围,即使生成较长的视频,也能有效管理资源消耗。

产品官网

- 官方项目主页:https://tencent.github.io/MimicMotion/

- GitHub源代码库:https://github.com/Tencent/MimicMotion

- arXiv技术论文:https://arxiv.org/abs/2406.19680

应用场景

MimicMotion可以广泛应用于多个领域,包括影视制作、游戏开发、动画创作、虚拟现实和增强现实等。在这些场景中,用户可以利用MimicMotion生成高质量的人类动作视频来增强视觉效果,提升用户体验。

常见问题

1. MimicMotion适合哪些类型的动作生成?

MimicMotion能够生成多种类型的动作视频,包括舞蹈、、日常活动等,只需提供相应的姿态序列即可。

2. 如何控制生成视频的时长?

用户可以根据需求在设置中指定视频的持续时间,从几秒到几分钟的长度均可调整。

3. 能否确保生成视频的质量?

MimicMotion采用了多种技术确保视频的高质量,包括置信度感知的姿态引导和区域损失放大等,特别关注细节表现。

4. 使用MimicMotion需要什么样的技术背景?

虽然MimicMotion为用户提供了高度定制化的功能,但基本的计算机视觉和视频编辑知识将有助于更好地使用该框架。

MimicMotion的技术原理

- 姿态引导的视频生成:MimicMotion根据用户提供的姿态序列作为输入,指导视频内容的生成,允许模型根据姿态变化合成相应动作。

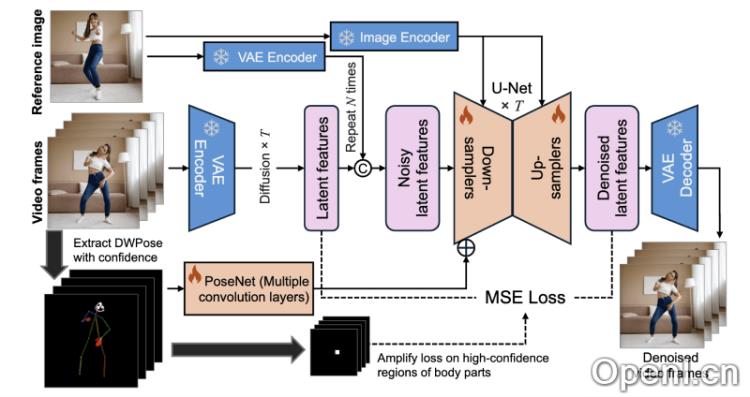

- 置信度感知的姿态指导:框架引入置信度分析,通过对姿态估计模型提供的置信度分数进行加权,使模型更加信赖高置信度的关键点,减少不准确姿态对生成结果的影响。

- 区域损失放大:MimicMotion重点关注手部等易失真区域,通过在损失函数中增加这些区域的权重,提升生成视频的手部细节质量。

- 潜在扩散模型:MimicMotion采用潜在扩散模型,以提高生成效率和质量,通过在低维潜在空间进行扩散过程,减少计算成本。

- 渐进式潜在融合:该技术在生成长视频时,通过逐步融合重叠帧的潜在特征,确保视频段之间的平滑过渡,避免闪烁和不连贯现象。

- 预训练模型的利用:MimicMotion基于一个预训练的视频生成模型(如Stable Video Diffusion,SVD),减少了从零开始训练模型所需的数据量和计算资源。

- U-Net和PoseNet的结构:MimicMotion的模型结构结合了用于空间时间交互的U-Net和提取姿态序列特征的PoseNet,协同工作以实现高质量视频生成。

- 跨帧平滑性:MimicMotion在生成过程中考虑帧间时间关系,确保视频帧之间的连贯性和平滑性。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号