ID-Animator是一种由腾讯光子工作室、中科大及中科院合肥物质科学研究院的科研团队推出的零样本(zero-shot)视频生成技术。它能够基于单张面部图像创建个性化视频,同时保留人物的身份特征,并可根据文本提示调整视频内容。通过结合预训练的文本到视频扩散模型和轻量级面部适配器,ID-Animator实现了高效的视频生成,无需对特定身份进行额外训练,从而提高了身份保真度与生成质量。

ID-Animator是什么

ID-Animator是一项创新的零样本人类视频生成技术,由来自腾讯光子工作室、中科大和中科院合肥物质科学研究院的专家们共同开发。该技术能够依据单一参考面部图像生成个性化视频,同时确保图像中的身份特征得以保留。用户还可以通过文本提示来调整视频内容,创造出丰富多样的场景和角色。ID-Animator通过结合预训练的文本到视频扩散模型与轻量级面部适配器,达到了高效的视频生成效果,无需针对特定身份进行额外训练。

ID-Animator的主要功能

- 角色上下文修改(Recontextualization):ID-Animator能够根据提供的参考图像和文本,改变视频中角色的上下文信息。例如,可以通过文本提示调整角色的发型、服装和背景,甚至实现特定动作,创造出全新的角色背景故事。

- 年龄与性别调整(Age and Gender Alteration):该模型支持根据需求对视频中角色的年龄和性别进行调整,以满足不同风格和内容的需求。例如,可以生成年轻人变老或男生化身女生的视频。

- 身份特征混合(Identity Mixing):ID-Animator能够将两种不同身份的特征进行混合,按不同的比例生成具备综合特征的视频,这在创造新角色或混合现实中的人物特征时特别有用。

- 与ControlNet的集成:ID-Animator可以与ControlNet等现有精细条件模块兼容,通过提供单帧或多帧控制图像,实现与控制图像紧密结合的视频序列生成,这在制作特定动作或场景的视频时非常有效。

- 社区模型集成:ID-Animator能够与社区模型(如Civitai上的模型)集成,即使没有经过这些模型的训练,依然能够有效运行,保持面部特征和动态生成的稳定性。

ID-Animator的官网入口

- 官方项目主页:https://id-animator.github.io/

- arXiv研究论文:https://arxiv.org/abs/2404.15275

- GitHub源代码:https://github.com/ID-Animator/ID-Animator

ID-Animator的工作原理

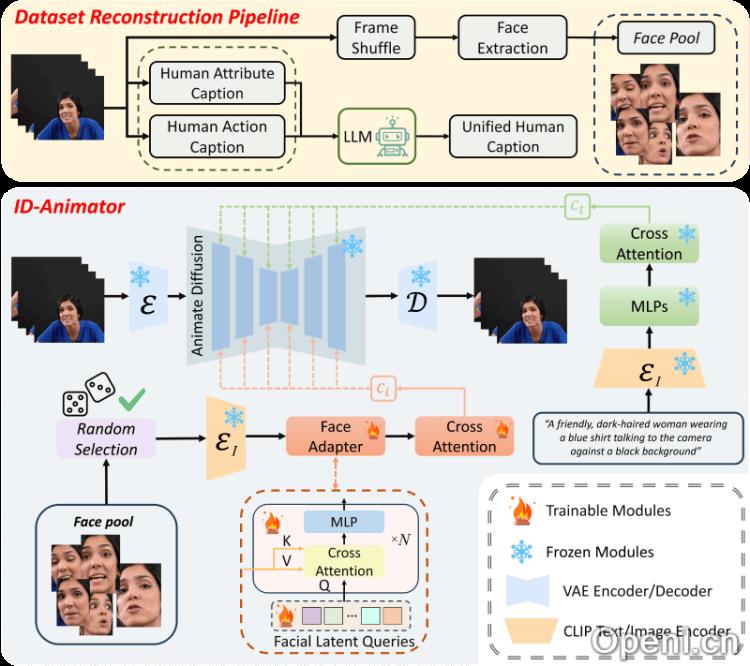

- 预训练的文本到视频扩散模型:ID-Animator基于一个预训练的文本到视频(Text-to-Video, T2V)扩散模型,该模型能够根据文本提示生成相应的视频内容。

- 面部适配器(Face Adapter):为了确保生成的视频与特定身份一致,ID-Animator引入了轻量级的面部适配器,通过学习面部潜在查询来编码与身份相关的嵌入信息。

- 身份导向的数据集构建:研究团队构建了一个专注于身份的数据集,内容包括解耦的人类属性和动作字幕技术,以及从构建的面部图像池中提取的面部特征。

- 随机面部参考训练方法:ID-Animator采用随机采样的面部图像进行训练,这种方法有助于将与身份无关的图像内容与与身份相关的面部特征分离,使适配器专注于学习身份特征。

- 文本与面部特征的融合:ID-Animator结合文本特征与面部特征,通过注意力机制进行融合,以生成符合文本描述且保留身份特征的视频。

- 生成过程:在生成视频时,ID-Animator首先接收一张参考面部图像和相关文本提示。面部适配器将参考图像的特征编码为嵌入,然后将这些嵌入与文本特征一起输入扩散模型,最终生成视频。

- 优化与训练:为了提升模型性能,ID-Animator的训练过程使用随机面部图像作为参考,减少参考图像中与身份无关特征的影响,并通过分类器引导等技术优化视频生成质量。

- 兼容性与扩展性:ID-Animator设计为与多种预训练的T2V模型兼容,如AnimateDiff,使其能够轻松集成到现有系统中,并在不同应用场景中扩展。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号