VideoCrafter2 是由腾讯AI实验室研发的一款创新视频生成模型,旨在解决高质量视频数据获取的难题。该模型的核心理念是将视频生成过程分为(motion)和外观(appearance)两个主要部分,从而在缺乏高质量视频素材的情况下,依然能够生成清晰且富有视觉冲击力的视频内容。通过低质量视频确保的连贯性,同时利用高质量图像来提升生成视频的画面质量。

什么是 VideoCrafter2?

VideoCrafter2是腾讯AI实验室推出的一种视频生成模型,旨在应对获得高质量视频数据的挑战。该模型通过解构视频生成过程,将其分为和外观两个部分,从而实现高质量视频的生成。它利用低质量视频来维护的一致性,并借助高质量的图像来确保视频的画面效果和概念的多样性。

项目主页:https://ailab-cvc.github.io/videocrafter2/

论文地址:https://arxiv.org/abs/2401.09047

GitHub代码库:https://github.com/AILab-CVC/VideoCrafter

Hugging Face Demo:https://huggingface.co/spaces/VideoCrafter/VideoCrafter2

主要功能

- 文本转视频:用户只需输入一段描述性的文本,VideoCrafter2便能根据该文本生成相应的视频。

- 高质量视频生成:该模型能够创造出高分辨率和优质视觉效果的视频,展现出丰富的细节和自然的表现。

- 美学效果提升:通过分开处理和外观,VideoCrafter2在保持视频连贯性的同时,也提升了清晰度、色彩饱和度等视觉效果。

- 概念组合:模型具备理解和组合复杂概念的能力,能够生成包含多个现实或虚拟元素和场景的视频。

- 多样的艺术风格:VideoCrafter2能够模拟不同的艺术风格,如赛博朋克、新波普等,给予视频创作更多的创意空间。

工作原理

VideoCrafter2的工作依托于深度学习和扩散模型的原理,通过以下几个关键步骤实现从文本到视频的生成:

- 数据解耦:将视频内容的生成分为和外观两个部分,前者负责物体的移动,后者关注图像的清晰度和细节。

- 学习:利用低质量视频数据集(如WebVid-10M)训练部分,确保生成视频在上保持连贯。

- 外观学习:使用高质量图像数据集(如Midjourney生成的JDB图像)训练外观部分,以提升生成视频的视觉质量。

- 模型训练:联合训练低质量视频和高分辨率图像,初步建立基础视频模型,随后通过微调外观模块进一步提升画质。

- 增强概念组合能力:使用合成图像数据集帮助模型学习如何融合不同元素和场景。

- 生成过程:根据文本提示,模型提取关键信息,结合和外观知识逐帧生成完整视频序列。

- 评估和优化:通过定量和定性评估,如EvalCrafter基准测试,评估生成视频的质量,并进行后续优化。

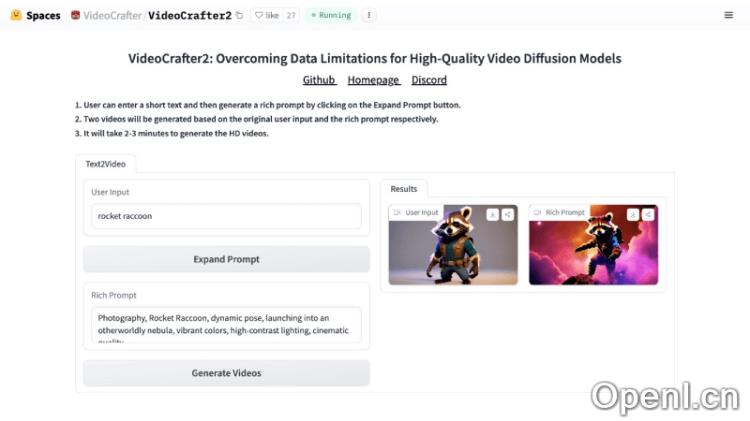

如何使用 VideoCrafter2

- 访问VideoCrafter2的官方网站或Hugging Face空间,在用户输入框中输入简短的文本描述。

- 点击“Expand Prompt”按钮以生成更丰富的提示描述。

- 随后点击“Generate Videos”,系统会根据原始输入和扩展提示分别生成两个视频。

- 生成高清视频的过程大约需要2-3分钟。

应用场景

VideoCrafter2可以广泛应用于影视制作、广告创意、游戏开发、教育培训等多个领域,帮助创作者提升创意表达和视频效果。

常见问题

1. VideoCrafter2支持哪些输入格式?

用户可以输入文本描述,系统将根据描述生成视频。

2. 生成视频的时间是多久?

通常生成高清视频需要2-3分钟。

3. 如何获取生成的视频?

生成的视频会显示在页面上,用户可以进行下载和分享。

粤公网安备 44011502001135号

粤公网安备 44011502001135号