StableV2V是什么

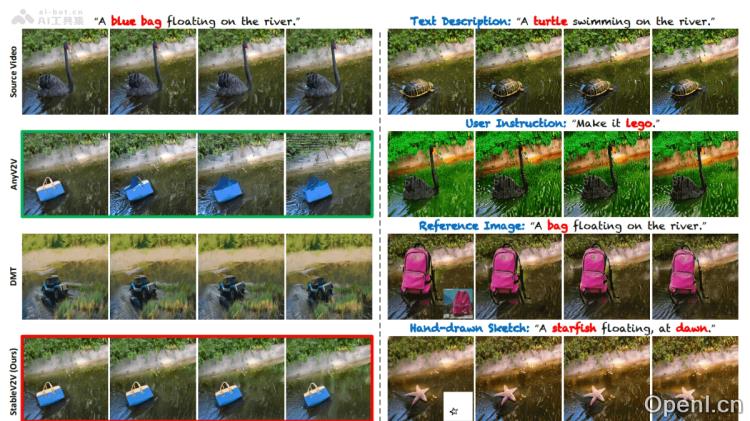

StableV2V是中国科技大学推出的一款开源视频编辑工具,旨在通过文本、草图和图片等多种输入方式,实现视频中对象的精确编辑与替换。该项目采用形状一致性编辑的理念,基于三个核心组件:Prompted First-frame Editor(PFE)、Iterative Shape Aligner(ISA)和Conditional Image-to-video Generator(CIG),确保编辑内容在动作和深度信息上与原始视频高度一致,从而生成自然流畅的编辑视频。

StableV2V的主要功能

- 多样化输入支持:能够处理多种输入形式,包括文本、草图和图片,方便用户在视频中进行对象的编辑和替换。

- 保持形状一致性:即使在对象形状发生显著变化的情况下,也能保证编辑后的视频内容在形状和上与原始视频保持一致。

- 灵活处理用户提示:能够根据不同类型的用户提示进行灵活处理,为创意提供更广阔的空间。

- 高质量视频输出:生成的视频具备卓越的视觉效果,确保编辑质量达到高标准。

StableV2V的技术原理

- Prompted First-frame Editor (PFE):作为编辑流程的起点,PFE将用户提供的提示(如文本、图像或草图)转换为视频的第一帧内容。

- Iterative Shape Aligner (ISA):

- ISA假设编辑内容与原始内容共享相同的和深度信息,并利用深度图作为传递信息的媒介。

- 通过模拟和深度模拟过程,ISA能够计算和传播平均、形状及深度信息。

- 使用形状引导的深度细化网络对深度图进行优化,确保物体与周围环境的交互自然合理。

- Conditional Image-to-video Generator (CIG):

- CIG负责将编辑后的第一帧和优化后的深度图转换为完整的编辑视频。

- 通过Ctrl-Adapter作为控制器,将深度图信息融入生成过程中。

- 利用I2VGen-XL,将编辑内容从第一帧扩展至整个视频序列,生成高质量的编辑视频。

- 深度信息的关键作用:深度图在传递信息和指导视频生成中发挥了重要作用,确保编辑内容的深度和与原始视频保持一致。

- 组件协同工作:PFE、ISA和CIG三个组件的紧密合作,确保从第一帧编辑到视频生成的整个过程保持高度一致和自然。

StableV2V的项目地址

- 项目官网:alonzoleeeooo.github.io/StableV2V

- GitHub仓库:https://github.com/AlonzoLeeeooo/StableV2V

- HuggingFace模型库:https://huggingface.co/AlonzoLeeeooo/StableV2V

- arXiv技术论文:https://arxiv.org/pdf/2411.11045

StableV2V的应用场景

- 电影和视频制作:在特效制作、场景转换和角色替换中应用,创造出无需重新拍摄的创新视觉效果。

- 社交媒体内容创作:帮助内容创作者迅速编辑视频,提升视频的吸引力和创意,例如将普通场景转变为艺术风格作品。

- 教育和培训:制作教学视频,将抽象概念形象化,如历史场景重现或科学现象模拟,以及安全演练和技术操作示范。

- 新闻和报道:对现场视频进行编辑和增强,提供更清晰、具体的视觉报道,例如模拟自然灾害的发生过程。

- 广告和营销:创造更具吸引力的广告视频,将产品融入创意场景中,从而提升广告的吸引力和记忆度。

常见问题

- StableV2V支持哪些输入格式?:StableV2V支持文本、草图和图片等多种输入格式,用户可以根据需求选择适合的输入方式。

- 如何确保编辑后的视频质量?:StableV2V通过形状一致性和深度信息的优化,确保编辑后的视频质量和自然性。

- 项目是否开源?:是的,StableV2V是一个开源项目,用户可以在GitHub上获取源代码并进行修改和使用。

- StableV2V适合哪些用户使用?:该工具适合电影制作人、内容创作者、教育工作者及广告营销人员等多种用户群体。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号