HelloMeme:创新的表情与姿态迁移框架

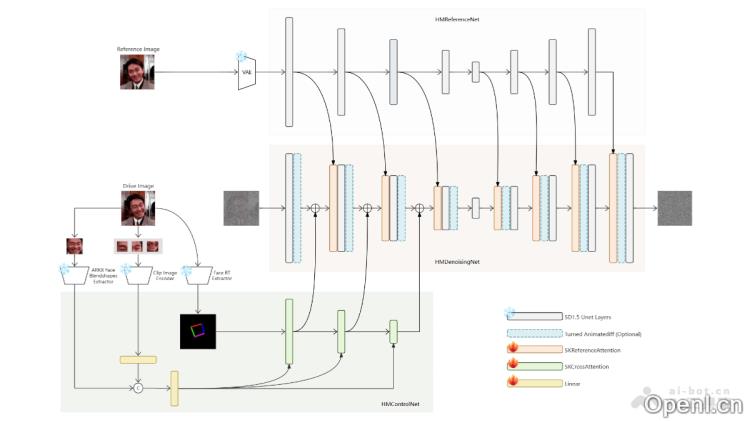

HelloMeme是一个基于前沿Diffusion生成技术的创新框架,旨在实现面部表情与头部姿态的高效迁移。该平台整合了空间编织注意力(Spatial Knitting Attentions)机制,并依托Stable Diffusion 1.5模型的强大理解能力,将面部表情与姿态信息巧妙融合于去噪网络中,从而生成自然且符合物理规律的表情包视频。HelloMeme不仅保持了基础模型的广泛适应性,且展现出扩展到全身或半身构图的潜力。

主要功能

– **表情与姿态迁移**:能够将驱动视频中的头部姿态和面部表情迁移到参考图像中,生成生动且富有表现力的动态视频内容。

– **保持泛化能力**:在处理复杂任务时,能够维持基础模型的泛化能力,制作出多样化的内容,超越特定任务的限制。

– **兼容性与扩展性**:与SD1.5衍生模型良好兼容,且具备扩展至全身或半身构图的应用潜力。

产品官网

– **项目官网**:songkey.github.io/hellomeme

– **GitHub仓库**:https://github.com/HelloVision/HelloMeme

– **arXiv技术论文**:https://arxiv.org/pdf/2410.22901

– **在线体验Demo**:https://www.modelscope.cn/studios/songkey/HelloMeme

应用场景

– **社交媒体内容创作**:用户能够生成个性化的表情包和视频,进一步提升社交媒体平台的互动性和娱乐性。

– **视频娱乐与游戏**:在视频游戏或虚拟现实环境中创造逼真的角色动画,增强沉浸式体验。

– **电影和视频制作**:帮助影视制作团队生成或增强角色的表情和动作,以降低实际拍摄的复杂性和成本。

– **广告与营销**:利用HelloMeme生成的动态图像和视频制作广告,吸引观众眼球,提高广告的吸引力和记忆度。

– **教育与培训**:在教育领域,使用HelloMeme制作生动有趣的教学视频,使学习内容更加生动活泼。

常见问题

1. **HelloMeme如何工作?**

HelloMeme通过空间编织注意力机制,将头部姿态和面部表情信息解耦并编码,然后融合生成自然流畅的视频。

2. **是否支持不同的输入格式?**

是的,HelloMeme支持多种输入格式,用户可以轻松上传参考图像和驱动视频。

3. **生成的视频质量如何?**

生成的视频具有高质量,能够实现自然的表情和姿态变化,符合物理规律。

4. **我可以在哪里找到HelloMeme的更多信息?**

您可以访问我们的官网或GitHub仓库,获取最新的项目更新和技术文档。

粤公网安备 44011502001135号

粤公网安备 44011502001135号