本文介绍了一套针对于低比特量化的 scaling laws。

原标题:低精度只适用于未充分训练的LLM?腾讯提出LLM量化的scaling laws

文章来源:机器之心

内容字数:5625字

腾讯AI Lab挑战低比特量化:充分训练的LLM量化损失巨大

本文总结了腾讯AI Lab发表在arXiv上的一篇论文,该论文挑战了低比特量化在大型语言模型(LLM)中的普遍适用性。研究发现,低比特量化仅在未充分训练的LLM上才能取得与fp16/bf16精度相当的性能,随着训练的深入,性能差距会显著扩大。

1. 低比特量化的局限性

近年来,低比特量化因其能够在降低模型规模、内存占用和计算资源的同时保持性能而备受关注。然而,腾讯AI Lab的研究表明,这种优势只存在于训练数据量较少的LLM中(通常小于5000亿tokens)。当模型充分训练后,低比特量化会导致显著的性能下降。

2. 实验设计与数据分析

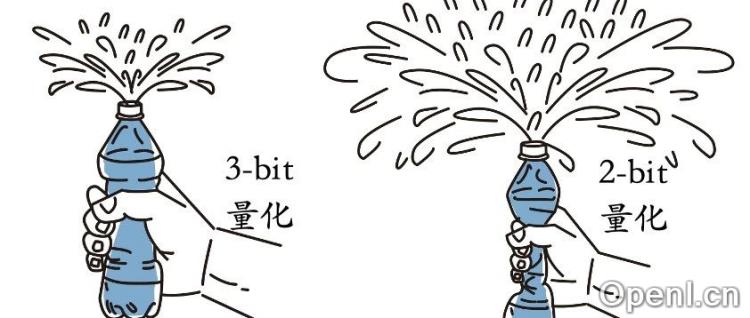

研究人员对超过1500个不同大小和训练程度的开源LLM检查点进行了量化实验,分析了量化引起的性能退化(QiD)。实验使用了Pythia系列模型,涵盖了不同尺寸(160M到12B参数)和训练阶段的检查点。通过GPTQ对这些检查点进行2-bit,3-bit,4-bit量化,并观察QiD的变化。

研究人员发现,在模型大小固定的情况下,训练数据量越多,QiD越大;在训练数据量固定的情况下,模型越小,QiD越大。这表明充分训练的模型更容易受到低比特量化的负面影响。

3. 低比特量化的Scaling Laws

基于实验结果,研究人员推导出一套低比特量化的scaling laws,该公式可以预测不同大小和训练程度的LLM在低比特量化下的性能损失:∆qLoss = k * Nα * Dβ * Pγ 。其中,N为模型参数量,D为训练数据量,P为量化精度(比特数),α、β、γ为正数指数,k为联合系数。

该公式表明,更大的模型(N)、更低的精度(P)会导致更小的QiD,而更大的训练数据量(D)会导致更大的QiD。

4. 权重变化与模型训练程度

研究人员认为,未充分训练的LLM权重变化幅度较大,对权重变化更鲁棒,因此低比特量化造成的偏差较小。而充分训练的LLM权重变化较小,低比特量化带来的额外变化更容易导致性能下降。

5. QiD作为衡量训练充分程度的指标

研究人员提出,QiD可以作为衡量LLM训练是否充分的指标。QiD接近0表明模型尚未充分训练,还有提升空间。利用scaling laws,可以预测不同尺寸的LLM达到指定QiD所需的训练数据量。

6. 对原生低比特LLM的讨论

研究也涵盖了原生低比特LLM,发现其规律与低比特量化类似,但性能下降可能在更晚的训练阶段才会显现。

7. 结论与展望

研究强调了在未充分训练的LLM上进行实验的局限性,呼吁社区重新审视基于此类实验得出的结论。随着模型训练数据量的不断增加,低比特量化在未来应用中的前景可能并不乐观。

联系作者

文章来源:机器之心

作者微信:

作者简介:专业的人工智能媒体和产业服务平台

粤公网安备 44011502001135号

粤公网安备 44011502001135号