InstructMove – 东京大合 Adobe 推出基于指令的图像编辑模型

InstructMove是什么

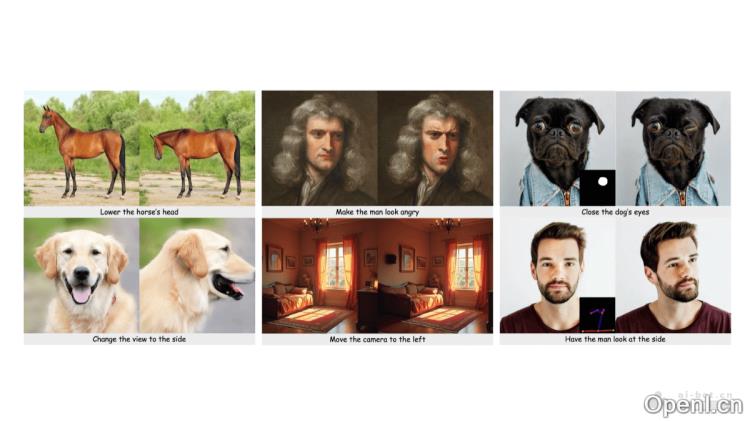

InstructMove是由东京大学与Adobe公司联合开发的一款基于指令的图像编辑模型。该模型通过分析视频帧之间的变化,学习如何根据用户指令进行图像处理。它运用多模态大型语言模型(MLLMs)生成描述帧对变换的编辑指令,具备在保持内容一致性的基础上,执行复杂的非刚性编辑任务的能力,例如调整主体的姿势、改变面部表情和视角等。InstructMove利用真实视频帧作为数据源,确保编辑过程的自然性和真实性,有效克服了合成数据集在复杂编辑任务中的不足。此外,InstructMove支持基于掩码等控制机制进行精准的局部编辑,进一步提升了其在实际应用中的灵活性和实用性。

InstructMove的主要功能

- 非刚性编辑:能够根据指令调整图像中主体的姿势、表情等非刚性特征。

- 视角调整:按指令改变图像的拍摄视角,例如将相机视角向左或向右移动,以改变图像的构图和视觉效果。

- 元素重新排列:对图像中的元素进行重新排序或移动,例如将玩具的腿放在一起,使鸟的尾巴更为显眼,以满足特定编辑需求。

- 精确局部编辑:结合掩码等控制机制,支持对图像特定区域进行精确的局部编辑,实现更细致的修改效果。

InstructMove的技术原理

- 数据集构建

- 视频帧采样:从互联网视频中获取帧对,确保帧对之间存在有意义的变化,例如主体姿势的变化、元素的移动或相机视角的调整,从而积累大量自然且真实的图像变换样本。

- 多模态语言模型生成指令:运用多模态大型语言模型(如GPT-4o或Pixtral-12B)分析采样得到的帧对差异,生成准确的编辑指令。

- 模型架构与训练

- 预训练模型微调:在构建的数据集上微调已有的文本到图像(T2I)模型,如Stable Diffusion。

- 空间条件策略:引入空间条件策略,将参考图像与噪声输入在空间维度上进行拼接,而非传统的通道拼接方式。

- 去噪网络训练:将拼接后的输入送入去噪U-Net网络,预测噪声图,计算预测噪声图与原始噪声图之间的差异,以优化模型参数,准确根据编辑指令对目标图像进行去噪和重建,实现图像编辑。

- 控制机制集成

- 掩码引导:支持与掩码等控制机制集成,实现精确的局部编辑。在推理阶段,利用掩码控制编辑区域,将更新后的潜在表示与参考潜在表示进行融合,以修改图像的特定部分。

- 其他空间控制:与ControlNet等可控扩散模型集成,接受用户提供的额外视觉线索(如草图或骨架关键点),以实现更复杂和精确的图像编辑操作。

InstructMove的项目地址

InstructMove的应用场景

- 影视后期制作:特效师可调整科幻电影中外星生物角色的表情,以更好地符合剧情需求,渲染出愤怒的情绪。

- 广告创意设计:设计师可以为汽车广告调整赛车的视角和背景元素,突出新车型的速度和,吸引消费者的目光。

- 室内设计:室内设计师可调整卧室床头柜的位置和窗帘样式,以满足客户对美观和实用性的要求,营造出温馨舒适的睡眠环境。

- 艺术教育:老师在绘画课程中可调整人物的动作,帮助学生理解动作与情感的关系,深化他们对艺术创作的理解。

- 个人照片编辑:个人用户可以调整聚会照片中的表情,使其更加自然轻松,以便分享到社交平台,获得朋友的点赞与好评。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号