GCDance – 萨里大学和江南大学推出的3D舞蹈生成框架

GCDance是什么

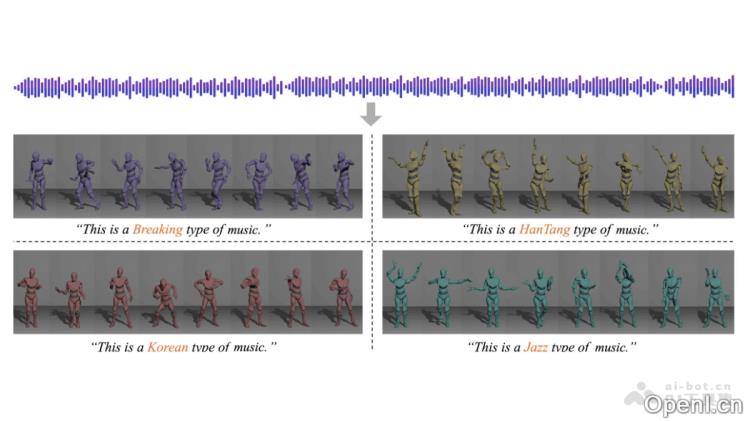

GCDance(Genre-Controlled 3D Full Body Dance Generation Driven by Music)是一款由英国萨里大学与江南大合开发的3D舞蹈生成框架。该系统能够根据音乐和文本提示生成特定风格的全身舞蹈序列。GCDance通过结合预训练的音乐基础模型(如Wav2CLIP)提取的高级音乐特征与手工设计的音乐特征(例如短时傅里叶变换STFT),实现了多层次的音乐特征融合。它利用CLIP模型将文本提示嵌入到舞蹈生成的每个时间步中,从而实现风格可控的舞蹈生成。GCDance支持在同一音乐片段下生成多种风格的舞蹈,确保舞蹈动作与音乐的节奏和旋律高度一致。

GCDance的主要功能

- 风格可调的舞蹈生成:用户可以根据文本提示指定舞蹈风格(如街舞、爵士舞等),生成与之相符的舞蹈动作。

- 与音乐节奏精确对齐:生成的舞蹈能够与音乐的节奏、拍子和旋律完美同步,确保舞蹈与音乐的自然融合。

- 多样化舞蹈生成:同一音乐片段可以生成多种不同风格的舞蹈,增强舞蹈的表现力和多样性。

- 支持局部编辑:用户能够对舞蹈的特定部分(如手部动作或特定时段)进行定制化调整。

- 生成高质量全身动作:涵盖52个关节(包括手指关节),生成的舞蹈动作自然流畅,具有较高的物理合理性。

GCDance的技术原理

- 扩散模型框架:基于无分类器扩散模型,通过逐步去噪的方式从随机噪声中生成舞蹈序列。

- 音乐特征提取:结合预训练的音乐基础模型(如Wav2CLIP)提取高级语义特征,同时利用手工设计的音乐特征(如短时傅里叶变换STFT)捕捉低层次的音乐细节。多粒度特征融合能够更好地捕捉音乐与舞蹈之间的复杂关系。

- 文本特征嵌入:利用CLIP模型将文本提示(如舞蹈风格描述)嵌入到每个舞蹈生成的时间步中,通过特征适配器与音乐特征对齐,实现风格可控的舞蹈生成。

- 特征调制(FiLM):特征调制层(Feature-wise Linear Modulation,FiLM)根据文本提示动态调整舞蹈生成过程,确保生成的舞蹈符合指定风格。

- 双流架构:针对身体动作和手部动作分别建模,采用两个Transformer网络处理,生成更细致且富有表现力的全身舞蹈动作。

- 编辑功能:基于扩散模型的编辑机制(如扩散修复),用户能够在生成过程中对舞蹈的特定部分施加约束,实现局部编辑和个性化生成。

GCDance的项目地址

- arXiv技术论文:https://arxiv.org/pdf/2502.18309

GCDance的应用场景

- 虚拟现实(VR)与增强现实(AR):为虚拟角色生成舞蹈,提升沉浸体验。

- 游戏开发:为游戏角色动态生成舞蹈动作,增强用户互动性。

- 舞蹈教学:辅助编舞和教学,提供多样化的舞蹈示例。

- 音乐视频制作:根据音乐自动生成舞蹈,提供创意素材。

- 智能健身:结合音乐生成健身舞蹈,提升锻炼的趣味性。

常见问题

- GCDance是否支持用户自定义舞蹈风格?是的,用户可以通过文本提示来指定舞蹈风格。

- 生成的舞蹈动作是否与音乐节奏一致?是的,GCDance确保生成的舞蹈动作与音乐的节奏和旋律高度同步。

- 用户能否对生成的舞蹈进行修改?是的,GCDance支持局部编辑,用户可以定制舞蹈的特定部分。

- GCDance适合哪些应用场景?GCDance广泛应用于虚拟现实、游戏开发、舞蹈教学、音乐视频制作和智能健身等领域。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号