MetaStone-L1-7B – 元石智算推出的轻量级推理模型

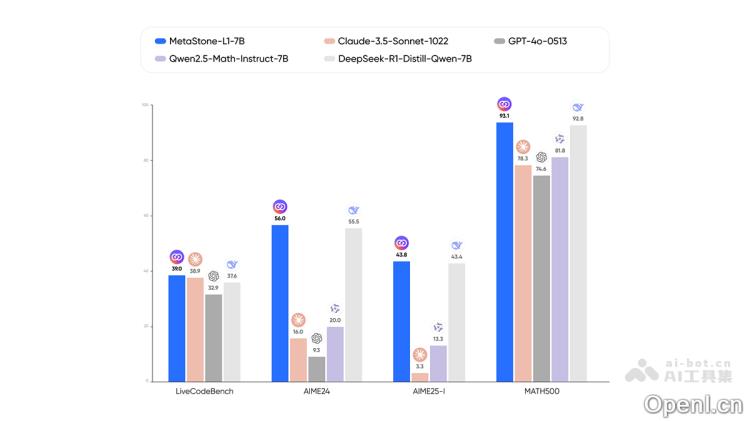

MetaStone-L1-7B 是一款轻量级推理模型,专为提升复杂任务的性能而打造,尤其在数学和代码领域表现卓越。它在核心推理基准测试中取得了并行模型的顶尖水平(SOTA),其性能与 Claude-3.5-Sonnet-1022 和 GPT4o-0513 等著名 API 模型不相上下。

MetaStone-L1-7B是什么

MetaStone-L1-7B 是 MetaStone 系列中的一款轻量级推理模型,旨在提升复杂下游任务的表现。它在数学与代码等关键推理基准测试中,达到了并行模型的顶尖水平(SOTA),与 Claude-3.5-Sonnet-1022 和 GPT4o-0513 等 API 模型的性能相当。该模型基于 DeepSeek-R1-Distill-Qwen-7B 由 GRPO 进行训练。

MetaStone-L1-7B的主要功能

- 卓越的推理能力:在数学和代码等核心推理基准测试中表现出色,取得并行模型的顶尖水平(SOTA),与 Claude-3.5-Sonnet-1022 和 GPT4o-0513 等 API 模型的性能相当。

- 优化的训练基础:基于 DeepSeek-R1-Distill-Qwen-7B 训练,具备强大的性能基础。

- 灵活的使用设置:推荐将温度设置为 0.6,顶部采样概率为 0.95,最大生成长度为 32k,以获得最佳性能。

- 针对特定任务的优化提示:对于数学问题,可在提示中附加“

Please reason step by step, and put your final answer within \\boxed{}.”;对于编程问题,添加特定格式要求,可以进一步提高模型的推理效果。

MetaStone-L1-7B的技术原理

- 基于 DeepSeek-R1 的技术架构:MetaStone-L1-7B 基于 DeepSeek-R1-Distill-Qwen-7B,通过 GRPO 训练而成。DeepSeek-R1 采用了先进的视觉强化微调(Visual Fine-Tuning, V-FT)技术,并结合跨模态对比学习、梯度解耦训练及注意力门控机制等创新方法,显著增强了模型的视觉理解和多模态对齐能力。

- 跨架构计算集群支持:元石智算提出了 RISC-V & x86 跨架构计算集群方案,通过“一云多芯”设计,兼容多种 CPU 架构,包括 RISC-V 和 x86。这使得 MetaStone-L1-7B 能够在不同计算资源上高效运行,充分利用不同体系架构 CPU 的性能。

- 云原生技术应用:元石智算创新性地提出了基于云原生技术的“MetaStone CloudOS”,为应用提供从容器、虚拟化、存储、网络、安全等全面的云基础设施能力。MetaStone CloudOS 突破了 RISC-V 架构集群与 x86/ARM 架构集群在资源调度上的壁垒,实现了真正的跨架构算力流动。

- 低参数量高效率设计:MetaStone-L1-7B 仅需 7B 的参数量便可达到传统多模态模型(如 Flamingo-80B)的图文理解能力。这种低参数量设计降低了计算资源需求,并通过混合精度训练和梯度检查点等技术,进一步提升了训练效率。

MetaStone-L1-7B的项目地址

- HuggingFace模型库:https://huggingface.co/MetaStoneTec/MetaStone-L1-7B

MetaStone-L1-7B的应用场景

- 数学问题解答:支持逐步推理并解决复杂数学问题,如完成平方、解方程等。用户只需输入问题,模型会按照要求逐步推理并给出最终答案,答案以特定格式(如

\boxed{})呈现,便于学习和理解。 - 编程辅助:对编程问题,模型可以生成符合要求的代码,并按照指定格式输出。例如,用户可以要求模型读取输入、解决问题并将结果写入输出,模型将生成相应代码片段。

- 智能客服:能够快速、准确地回答用户问题,提供解决方案与建议,提高客户服务的效率和质量。

- 内容创作:协助用户生成文本内容,如文章、故事和诗歌等,激发创作灵感。

- 代码生成与优化:根据用户需求生成相应代码,帮助开发者快速实现功能,提升开发效率。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号