AIGC动态欢迎阅读

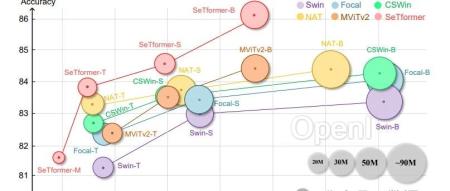

原标题:超过ConvNeXt,CSWin等!上海交大提出Transformer架构新SOTA:SeTformer!

关键字:模型,卷积,矩阵,特征,参数

文章来源:算法邦

内容字数:7178字

内容摘要:

直播预告 | 1月22日晚7点,「自动驾驶新青年讲座」第35讲正式开讲,LMDrive一作、香港中文大学MMLab在读博士邵昊将主讲《LMDrive:大语言模型加持的闭环端到端自动驾驶框架》,欢迎扫名~论文链接:https://arxiv.org/pdf/2401.03540.pd

01引言Transformer(变压器)最初是用于自然语言处理(NLP)的技术,在视觉领域得到了显著的流行,这要归功于Vision Transformer(ViT)的开创性工作它的优势已经在各种视觉任务中得到了证明,包括图像分类、目标检测、分割等。对于捕获长距离依赖关系,点积自注意力(DPSA)与softmax归一化在transformer中起着至关重要的作用。然而,该模型的计算导致了二次时间和内存复杂度,使得训练长序列模型变得困难。

02简介本文提出了SeTformer,一种新的transformer,其中DPSA完全被Self-optimal Transport (SeT)取代,以实现更好的性能和计算效率。SeT基于两个基本的softmax属性:保持非负的注意力矩阵和使用非线性的重新加权机制来强调输

原文链接:超过ConvNeXt,CSWin等!上海交大提出Transformer架构新SOTA:SeTformer!

联系作者

文章来源:算法邦

作者微信:allplusai

作者简介:「算法邦」,隶属于智猩猩,关注大模型、生成式AI、计算机视觉三大领域的研究与开发,提供技术文章、讲座、在线研讨会。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号