AIGC动态欢迎阅读

原标题:打乱/跳过Transformer层会怎样?最新研究揭开其信息流动机制,一口气解答8大问题

关键字:中间层,顺序,模型,表征,研究人员

文章来源:量子位

内容字数:0字

内容摘要:

西风 发自 凹非寺量子位 | 公众号 QbitAITransformer中的信息流动机制,被最新研究揭开了:

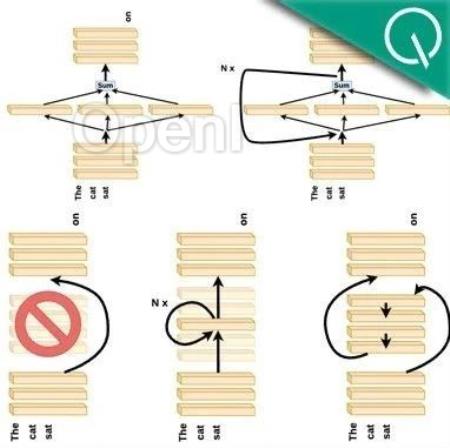

所有层都是必要的吗?中间层在做同样的事吗?层的顺序重要吗?

如果跳过一些层,比如第4层输出接到第6层会怎样。随乱层的顺序,比如4-6-5-7又会怎样。

最近一项名为“Transformer Layers as Painters”的研究火了,由来自AI初创公司Sakana AI、Emergence AI的研究团队完成。

他们从Transformer内部工作原理出发,经过一系列实验对以上问题得出了结论。团队表示深入理解这些原理不仅能提高现有模型利用效率,还能帮助改进架构开发新的变体。

谷歌DeepMind研究员、ViT作者Lucas Beyer看过后直接点了个赞:

很棒的总结!尽管一些实验在之前的研究中已经被展示过了,但我喜欢你添加的新细节,特别是强调了“推理”类任务比其他任务受影响更大!

还有不少学者、工程师也表示强烈推荐。

敢打赌,其中一些见解最终将会用于改进Transformer。

其中的实验再次证实了:复制层对创造性任务有帮助,但对推理任务通常无效;改变层的顺序行不通;

原文链接:打乱/跳过Transformer层会怎样?最新研究揭开其信息流动机制,一口气解答8大问题

联系作者

文章来源:量子位

作者微信:

作者简介:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号